Algumas semanas atrás, o único assunto que se comentava à respeito da OpenAI era sobre a saída inesperada de Sam Altman, o então CEO, da empresa. E enquanto o próprio Altman planejava seu retorno, a equipe de Superalinhamento da OpenAI continuava cuidadosamente trabalhando na questão de como controlar uma IA que é mais inteligente que os humanos.

Três membros dessa mesma equipe participaram de uma conferência sobre Machine Learning na última semana — Collin Burns, Pavel Izmailov e Leopold Aschenbrenner — a NeurIPS. Eles apresentaram o mais recente trabalho da OpenAI sobre como garantir que os sistemas de IA se comportem conforme o esperado.

A OpenAI criou a equipe de Superalinhamento em julho para desenvolver métodos que possam direcionar, regular e governar sistemas “superinteligentes” — ou seja, sistemas que teoricamente, possuem inteligência muito superior a dos seres humanos.

Eles também conversaram com o pessoal do TechCrunch a respeito disso tudo, nos fornecendo informações no mínimo curiosas, a respeito do futuro da OpenAI, da inteligência artificial e de sua relação com a humanidade.

Os planos da OpenAI

“Hoje obviamente podemos alinhar modelos que são menos inteligentes que nós, ou talvez no máximo que estão no nível humano de inteligência. Mas controlar um modelo que é realmente mais inteligente do que nós é muito menos óbvio, como podemos fazer isso?”

Collin Burns

O esforço de Superalinhamento está sendo liderado pelo co-fundador e cientista-chefe da OpenAI, Ilya Sutskever. Embora Superalinhamento seja um assunto um tanto delicado dentro da comunidade de pesquisa em inteligência artificial, alguns argumentam que o assunto ainda é prematuro, enquanto outros consideram que se trata de uma distração.

Enquanto Sam Altman fez comparações entre a OpenAI e o Projeto Manhattan, chegando até mesmo a montar uma equipe para investigar modelos de IA para proteger contra “riscos catastróficos”, alguns especialistas dizem que há poucas evidências que sugerem que a tecnologia ganhará capacidades de acabar com o mundo ou superar a inteligência humana tão cedo — ou até mesmo nunca.

Esses especialistas também afirmam que alegações de uma superinteligência iminente, servem apenas para desviar a atenção e distrair das questões urgentes da IA nos dias de hoje, como sua tendência para toxicidade e sua regulação necessária.

De qualquer forma, Suksever parece acreditar sinceramente que a Inteligência artificial — não necessariamente a da OpenAI — pode algum dia representar uma ameaça para a nossa existência. Além disso, ele demanda uma quantidade significativa do poder computacional da empresa — cerca de 20% de seus chips de computador existentes — para a pesquisa da equipe de Superalinhamento.

“O progresso da IA recentemente tem sido extraordinariamente rápido, e posso garantir que não está desacelerando,” disse Aschenbrenner. Ele também complementou, dizendo:

Acho que vamos alcançar sistemas ao nível humano muito em breve, mas não vai parar por aí — vamos avançar para sistemas super-humanos… Então, como controlamos sistemas de IA super-humanos e os tornamos seguros? É realmente um problema para toda a humanidade — talvez o problema técnico não resolvido mais importante do nosso tempo.”

Aschenbrenner

Até onde a IA deve chegar?

Atualmente, a equipe de Superalinhamento está tentando construir estruturas de controle que possam ser bem aplicadas a futuros sistemas poderosos de IA. Não é uma tarefa simples, considerando a definição de “superinteligência” se torna abstrata à medida que refletimos sobre.

Você já parou pra pensar sobre quais níveis a IA pode alcançar algum dia? E além disso: tratando-se de uma ferramenta senciente — que possui controle, pensamento e desenvolvimento próprio — até onde isso tudo vai chegar? Esse assunto é objeto de intenso debate.

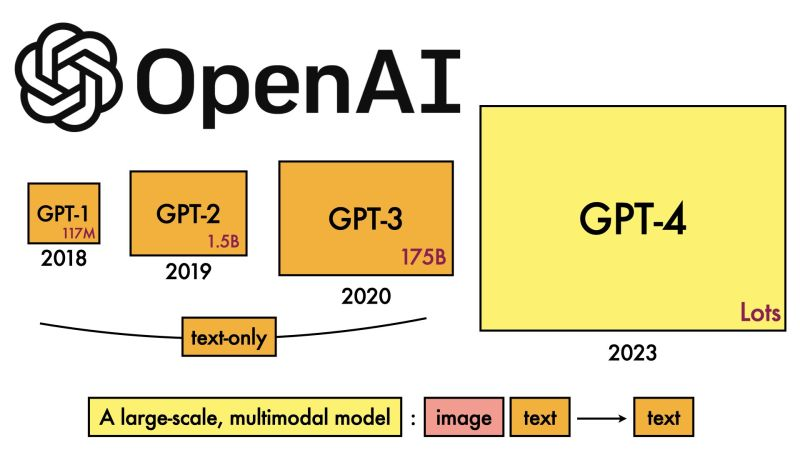

Mas a abordagem que a equipe adotou por enquanto envolve usar um modelo de IA mais fraco e menos sofisticado (o GPT-2, por exemplo) para guiar um modelo mais avançado e sofisticado (GPT-4) em direções desejáveis — e afastá-lo das indesejáveis.

“O que a gente quer fazer é dizer para um modelo o que fazer e garantir que ele vai fazer,” disse Burns. “Como a gente faz para um modelo seguir instruções e ajudar só com coisas que são verdadeiras e não inventar nada? Como a gente faz para um modelo nos dizer se o código que ele gerou é seguro ou um comportamento absurdo? Esses são os tipos de tarefas que a gente quer conseguir com a nossa pesquisa.”

Você pode estar se perguntando agora “o que tem a ver uma IA guiando outra IA, a com evitar uma IA que ameace a existência da humanidade?“ Bom, se trata de uma analogia: o modelo fraco representa um ser humano, com capacidade limitada, enquanto o modelo forte representa a IA superinteligente.

Assim como os humanos que podem não entender um sistema de IA superinteligente, o modelo fraco não consegue “entender” todas as complexidades e nuances do modelo mais forte — o que torna o cenário útil para testar hipóteses, afirma a equipe de Superalinhamento.

“Seria algo como um aluno do sexto ano tentando supervisionar um aluno da faculdade,” explicou Izmailov. “Digamos que o aluno do sexto ano está tentando explicar para o aluno da faculdade uma tarefa que ele meio que sabe resolver… Mesmo que a supervisão do aluno do sexto ano tenha erros nos detalhes, há uma esperança de que o aluno da faculdade entenda a ideia geral e consiga fazer a tarefa melhor do que o supervisor.”

No cenário criado pela equipe de Superalinhamento, um modelo fraco ajustado para uma tarefa específica gera rótulos que são usados para “comunicar” os traços gerais dessa tarefa para o modelo mais forte. Dados esses rótulos, o modelo forte pode generalizar mais ou menos corretamente de acordo com a intenção do modelo fraco — mesmo que os rótulos do modelo fraco contenham erros.

A abordagem de modelo fraco-forte pode até levar a avanços na área de alucinações, afirma a equipe.

“Alucinações são bem interessantes, porque internamente, o modelo sabe se o que ele está dizendo é fato ou ficção,” disse Aschenbrenner. “Mas do jeito que esses modelos são treinados hoje, supervisores humanos recompensam eles com ‘joinha’, ‘dedinho para baixo’ por dizer coisas.

Então, às vezes, sem querer, os humanos recompensam o modelo por dizer coisas que são falsas ou que o modelo nem sabe direito e por aí vai. Se a gente tiver sucesso em nossa pesquisa, devemos desenvolver técnicas onde a gente pode basicamente invocar o conhecimento do modelo e aplicar essa invocação para saber se algo é fato ou ficção e usar isso para reduzir alucinações.”

Mas a analogia não é perfeita. Então, a OpenAI quer receber ideias de outras pessoas.

Para isso, a OpenAI está lançando um programa de bolsas avaliado em US$10 milhões para apoiar pesquisas técnicas sobre Superalinhamento, reservando partes desse investimento para laboratórios acadêmicos, ONGs, pesquisadores individuais e estudantes de pós-graduação. A OpenAI também planeja realizar uma conferência acadêmica sobre Superalinhamento no início de 2025, onde vai compartilhar e promover o trabalho dos finalistas do prêmio.

Curiosamente, uma parte do financiamento para a bolsa virá do ex-CEO e presidente do Google, Eric Schmidt. Ele é um fervoroso apoiador de Altman, e está se tornando um símbolo do pessimismo com relação ao desenvolvimento da IA, afirmando que a chegada de sistemas perigosos está próxima e que os reguladores não estão fazendo o suficiente para se preparar.

E se engana quem pensa que esse investimento acontece por um senso de altruísmo ou preocupação com a humanidade. Reportagens publicadas no Protocol e no Wired expõem que Schmidt, um investidor ativo em IA, se beneficiaria comercialmente se o governo dos EUA implementasse seu plano proposto para fortalecer pesquisas na área.

“A AI e outras tecnologias emergentes estão mudando a nossa economia e sociedade,” disse Schmidt em um comunicado por email. “Garantir que elas estejam alinhadas com os valores humanos é fundamental, e eu tenho orgulho de apoiar as novas (bolsas) da OpenAI para desenvolver e controlar a IA de forma responsável para o bem público.”

De fato, a participação de uma figura com motivações comerciais tão claras levanta a questão: a pesquisa de Superalinhamento da OpenAI, bem como a pesquisa que ela está incentivando a comunidade a enviar para sua futura conferência, estarão disponíveis para qualquer um usar como quiser?

“Contribuir não só para a segurança dos nossos modelos, mas também para a segurança dos modelos de outros laboratórios e da IA avançada em geral faz parte da nossa missão,” disse Aschenbrenner.

“É realmente essencial para a nossa missão de construir a IA, para o benefício de toda a humanidade, com segurança. E a gente acha que fazer essa pesquisa é absolutamente necessário para tornar a IA benéfica e segura.”

Nos resta esperar os resultados dessa pesquisa e imaginar quais serão os reais impactos da inteligência artificial em nosso futuro. Agora eu quero saber a sua opinião: O que você acha que vai acontecer de fato, quando as IAs se tornarem superinteligentes? Será que conseguiremos manter o controle da situação? Conta pra gente!

Só não esquece de marcar o @canaljms nas redes sociais!

Com informações do TechCrunch

Grupo Whatsapp

Grupo Whatsapp

Grupo Telegram

Grupo Telegram